Introduction

Lors du chapitre précédent, nous avons défini le document comme étant l’objet au cœur du processus de publication scientifique. Qu’il s’agisse des premières revues savantes datant du XVIIe siècle ou des revues numériques contemporaines, des lettres ou encore des livres, un document est nécessaire pour fabriquer cet objet éditorial (Fauchié, 2024). Ce document, dans sa forme (Briet, 1951; Buckland, 1997; Otlet, 2015), dans la structuration des informations qu’il contient (Pédauque, 2003; Zacklad, 2019) et dans son rôle de médiateur (Pédauque, 2006) dépasse son statut de simple support de l’information. Le support n’est alors plus considéré comme un élément neutre et devient, de par sa matérialité, un élément constitutif du sens accordé au message qu’il porte.

Puisqu’il n’est pas un simple support, nous nous intéresserons dans ce chapitre à la matérialisation de ce document scientifique dans un environnement d’écriture numérique. Comme énoncé dans le chapitre précédent, un document numérique est un espace délimité dans lequel sont organisées des informations selon un agencement de normes établies par les impératifs d’une chaîne de traitements, par exemple avec des protocoles de communication des documents ou encore des formats. Cet espace alloué physiquement dans la mémoire de l’ordinateur va être modifié, l’agencement primaire des informations y sera transformé en un autre objet ou transporté en un autre espace, produisant ainsi un nouvel agencement documentaire.

Les documents numériques ayant pour devenir la publication scientifique font principalement l’objet d’un traitement éditorial de l’information : saisie du texte dans un format de traitement de texte ou de texte brut, conversions dans divers formats de document, transformations du texte source selon des normes éditoriales ou à la suite d’une relecture par les pairs, publication dans un nouvel espace selon un format lié à cette action (que l’objet soit imprimé ou publié en version numérique) (Pédauque, 2007).

Dans cette chaîne, la réalisation d’un artefact publiable, c’est-à-dire un document dans sa version finale, nécessite des interactions entre une multitude d’agents pour advenir, qu’ils soient numériques ou humains. Qu’il s’agisse de l’adaptation des références bibliographiques à une norme donnée, de l’ajout des espaces fines insécables dans le texte, de la modification ou correction de certaines sources d’information, ces étapes de l’élaboration du document ainsi que toutes les autres proviennent des interactions entre des individus et l’environnement support (Merzeau, 2013; Paveau, 2012; Zacklad, 2012) qui produisent des traces à l’intérieur du document que nous considérons comme constitutives d’une épistémologie du document. Elles sont les indices de ces interactions passées et incarnent un modèle de représentation du document et par extension de la publication scientifique concernée. Plutôt que de nous intéresser au document final tel qu’il est publié, nous nous focalisons sur les interactions qui le précèdent et sur une épistémologie du document en cours de matérialisation.

Nous consacrons ce chapitre aux premières interactions à l’origine de la publication scientifique : la création du document primaire de la chaîne de publication. Pour ce faire, nous observerons les traces issues des interactions entre un auteur et un ordinateur dans le document numérique1.

En ce sens, l’acte d’écriture numérique n’est plus défini en tant que fruit d’une seule fonction auctoriale, mais l’est par un ensemble de fonctions éditoriales dont la fonction auctoriale fait partie (Jeanneret & Souchier, 2005; Souchier, 1998; Paveau, 2015).

Ainsi, parmi toutes les fonctions éditoriales que l’on pourrait énumérer, nous nous intéressons dans ce chapitre à la première phase de matérialisation du document : la saisie du texte dans un environnement support. Lors de cette phase de matérialisation, le document devient le lieu où se manifeste un trouble entre ce que l’usager à l’intention d’écrire et le texte que produit la machine, structuré selon les formats et protocoles implémentés à l’intérieur de l’écosystème. Ce trouble naît de la rencontre entre une représentation du document structuré graphiquement, essentiellement culturelle, et une représentation du document structuré par du texte, comme c’est le cas pour une page web interprétée par un navigateur et son pendant au format HTML. Notre intérêt se porte plus particulièrement sur le côté machine de cette relation humain-machine et sur la manière dont cette machine reçoit et traite les informations pour produire le document dans un environnement particulier.

Afin de traiter cette problématique, nous décrivons dans une première partie les particularités de l’écriture en environnement numérique (Bouchardon, 2014; Crozat, 2016; Souchier, 2019) et le fonctionnement d’un ordinateur, pré-requis nécessaires à la matérialisation d’un document numérique. Ces propriétés illustrent la nécessité d’avoir un intermédiaire, le logiciel, dans cette relation humain-machine. En nous affranchissant de la page affichée à l’écran, une deuxième partie est accordée à ce rôle de médiation joué par les logiciels – entendus comme une suite d’instructions écrites – entre la saisie du texte au clavier et les traitements appliqués à ces informations, jusqu’à leur stockage dans une mémoire informatique. Au-delà de la page, nous explorons les différentes phases documentaires que traverse le texte pour être inscrit sur son support et faire document.

Tandis que chaque environnement a ses propres modalités d’écriture que nous ne pouvons pas toutes énumérer, nous nous appuyons dans la deuxième partie de ce chapitre sur l’étude de l’éditeur de texte sémantique Stylo et les différentes modélisations du texte qu’il génère2. Ces modèles intermédiaires circulent entre les espaces de Stylo – client et serveur – par différents canaux et protocoles pour former, à travers une série de documents produits, une dynamique constitutive du sens de l’écriture propre à cet environnement (Merzeau, 2013).

Stylo est un éditeur de texte sémantique en ligne développé pour l’édition savante en sciences humaines et sociales (SHS) et en lettres. Stylo est autant un projet de recherche qu’un outil d’écriture et d’édition, qui entend poser une question décisive : qu’est-ce qu’écrire en environnement numérique en SHS ?

C’est un outil libre et open source conçu en 2017 par la Chaire de recherche du Canada sur les écritures numériques (CRCEN) (Vitali-Rosati et al., 2020), et soutenu depuis 2020 par la Très grande infrastructure de recherche Huma-num. Guillaume Grossetie et Thomas Parisot, tous deux développeurs, maintiennent et développent l’infrastructure technique de Stylo avec la CRCEN depuis plusieurs années, équipe dans laquelle je suis fortement impliqué depuis le début de l’année 2022.

Stylo a pour objectif de transformer le flux de travail numérique des revues savantes en SHS. En tant qu’éditeur de texte sémantique WYSIWYM (What You See Is What You Mean), il vise à améliorer la chaîne de publication académique (Kembellec, 2020), tout en invitant à une réflexion théorique et pratique sur nos façons d’écrire et d’éditer.

Prendre le contrôle de son propre texte, voilà ce que permet aujourd’hui Stylo à travers plusieurs fonctionnalités fondatrices ou plus récentes qui s’inscrivent dans le domaine des technologies de l’édition numérique (Blanc & Haute, 2018) : balisage du texte pour une structure sémantique fine, import de données bibliographiques structurées depuis l’application Zotero, mot-clés contrôlés depuis plusieurs ontologies, prévisualisation avec la possibilité d’annoter avec Hypothesis, génération de plusieurs formats (HTML, PDF, XML ou DOCX), export respectant les standards de l’édition scientifique, fonctions avancées de rechercher-remplacer, édition collaborative simultanée, accès aux données via une API GraphQL, etc. Contrairement aux outils de traitement de texte tels que Microsoft Word ou LibreOffice, Stylo cherche à promouvoir et à encourager l’utilisation de standards ouverts.

Au cœur de Stylo ce sont donc les formats de balisage Markdown, de sérialisation de données YAML ou encore de structuration de références bibliographiques BibTeX qui offrent la possibilité de produire plusieurs formats de sortie depuis une source unique. Stylo suit donc le principe de single source publishing (Fauchié, 2024). En s’appuyant sur Pandoc, un outil de conversion de documents désigné comme le « couteau suisse de l’édition », le module d’export de Stylo génère les formats de sortie PDF (avec l’aide de LaTeX), HTML, XML-TEI, DOCX ou encore XML compatible avec le schéma COMMONS Publishing commun à Métopes, Cairn et OpenEdition.

Le choix d’étudier Stylo comme terrain pour cette recherche découle de plusieurs raisons. Tout d’abord, il s’agit d’un éditeur moderne construit avec les technologies du Web les plus récentes. Que ce soit à travers des environnements tels que Stylo, GoogleDoc, Hedgedoc ou encore Framapad, les environnements d’écriture en ligne (Web) suscitent un certain engouement auprès des utilisateurs notamment pour leur capacité à offrir un espace de travail collaboratif en temps réel leur permettant d’écrire à plusieurs dans cet espace. La deuxième raison qui fait de Stylo un terrain opportun est l’accessibilité de son code source. Contrairement à d’autres éditeurs propriétaires comme l’est GoogleDoc, la totalité du code de Stylo est disponible en ligne, ce qui est indispensable pour notre étude. Enfin, le fait d’être impliqué dans les développements de Stylo depuis plus de deux ans m’offre une position privilégiée pour étudier cet éditeur puisque j’ai accès aux différentes phases de tests des développements, me permettant ainsi d’observer le comportement des nouvelles fonctionnalités et de participer à leur modification. Depuis cette position, j’ai également un accès direct à la communauté d’utilisateurs, s’élevant à un peu plus de 6000 personnes fin 2023 pour plus de 40 000 documents différents.

Du fait de mon implication dans Stylo, le regard que je porte sur ce terrain n’est pas neutre et relève d’une forme de recherche-action [ajouter une référence].

Alors que chaque caractère, chaque trace inscrite dans l’éditeur de texte Stylo incarne cette tension entre l’utilisateur et la machine, dont les différences de langage – naturel et machine – rend a priori toute communication directe impossible, nous analysons les différents modes de communication des informations dans Stylo pour suivre la circulation de ces traces et leur empreinte dans le document. Pour en découvrir plus sur cet entre, nous étudions cette distance à partir de la méthode employée par le théoricien des médias F. Kittler (F. Kittler, 2018; 2015), qui s’appuie d’abord sur la description du fonctionnement de la machine à écrire puis celle de l’ordinateur afin de comprendre leur implication, en tant que média, dans le phénomène qu’est l’écriture. Cette méthode implique de comprendre les comportements et les fonctionnements techniques des composants à l’œuvre dans la machine, qu’ils relèvent du matériel ou du logiciel. En conséquence, nous mobilisons de la documentation technique pour étayer notre propos et pour analyser les traces des interactions qui nous intéressent.

À partir de cette étude, nous verrons qu’à l’intérieur de cet entre les traces de cette relation s’accumulent en une série de documents intermédiaires cachés sous la page alors qu’ils sont nécessaires et primordiaux en ce qu’ils constituent les étapes de la matérialisation de ce que nous nommons le document primaire.

Écrire dans un environnement numérique

Par habitude, nous partons du présupposé que lorsque nous évoquons les mots environnement d’écriture numérique, ceux-ci sont synonymes d’un environnement d’écriture informatique et désignent la même chose. En conséquence, lorsqu’il s’agit de convoquer l’écriture numérique, nous pensons tout de suite à un ordinateur, aux claviers, aux écrans et aux pointeurs qui clignotent dans des éditeurs de texte ou dans les champs des formulaires en ligne. Avec le numérique ubiquitaire (Citton et al., 2023), ces pratiques d’écriture sont ancrées dans nos habitudes au point de ne plus les remettre en question. Les dispositifs d’écriture analogique sont ainsi renvoyés à l’état de vestiges archaïques, comme peuvent l’être les machines à écrire alors qu’elles ont été fabriquées méticuleusement par des designers et des ingénieurs. Elles ont par ailleurs fait la fierté et la renommée de certaines entreprises comme Olivetti en Italie juste avant que les ordinateurs personnels n’arrivent sur le marché. Aujourd’hui ces machines sont complètement désuètes et inutilisées depuis presque une trentaine d’années. Elles sont maintenant exposées dans des musées – entre autres au MoMA et au Centre Pompidou – et sont intégrées dans des collections permanentes ou exhibées lors des expositions en lien avec les designers qui les ont conçues3.

Crédits : © Adagp, Paris. Crédit photographique : Georges Meguerditchian - Centre Pompidou, MNAM-CCI /Dist. RMN-GP. Réf. image : 4N40151. Diffusion image : l’Agence Photo de la RMN

Crédits : © Adagp, Paris. Crédit photographique : Jean-Claude Planchet - Centre Pompidou, MNAM-CCI /Dist. RMN-GP. Réf. image : 4F40212 [2003 CX 6098]. Diffusion image : l’Agence Photo de la RMN

Pourtant, les derniers modèles fabriqués par ces entreprises l’ont été dans les années 1980 et 1990, comme c’est le cas du modèle ETP 55 Portable4 où sont intégrés des composants électroniques pour suivre le marché des ordinateurs. Les constructeurs ont opéré un changement de paradigme de l’analogique vers le numérique dès les années 1970 et ont suivi les innovations technologiques apportées par la miniaturisation des composants électroniques pour l’informatique. Pour preuve, en 1983, Perry A. King et Antonio Macchi Cassia conçoivent le premier ordinateur personnel d’Olivetti avec le modèle M10 en adaptant un clavier à un écran à cristaux liquide. Cet ordinateur, équipé du processeur Intel 80C85 en 8-bits, pouvait également se connecter à tout un ensemble de périphériques comme des imprimantes.

Crédits : Photo trouvée sur le blog Munk.org, site consulté le 22 février 2024.

Il faut se rappeler qu’au début des années 1980 il n’est pas encore certain que l’ordinateur personnel (avec sa tour et son écran à tube cathodique) deviendra l’outil d’écriture par excellence. À cette époque, les machines à écrire ont encore quelques avantages sur les plans esthétique, financier et social puisque ce sont des objets que l’on retrouve encore présents dans les bureaux professionnels ou personnels.

La fin des années 1970 et les années 1980 marquent un tournant décisif pour l’ordinateur personnel avec l’apparition des logiciels de traitement de texte et la bataille qui sévit durant toute cette période pour en avoir le monopole. M. Kirschenbaum et T. Bergin détaillent dans leurs travaux cette course au développement de logiciels durant cette décennie, dans le but d’obtenir un monopole sur le marché de la production documentaire avec un ordinateur (Bergin, 2006a, 2006b; Kirschenbaum, 2016). Avant l’engouement pour les interfaces graphiques et les gestionnaires de fenêtres – 1983 et 1984 avec l’entreprise Apple qui s’est largement inspirée des interfaces graphiques développées par Xerox PARC dans les années 1970 – la seule interface affichée à l’écran était un terminal, un écran noir où clignote un curseur. Dans cette interface, la navigation s’y faisait au moyen de commandes. C’est ce que nous retrouvons avec les premiers logiciels de traitement de texte comme Electric Pencil. Ils ne permettent pas une gestion fine de la mise en page ni ne fonctionnent sur tous les modèles d’ordinateurs présents sur le marché5. Ainsi, écrire sur un support connecté paraît aujourd’hui être une évidence alors que de lourds efforts ont été déployés à une époque ou cette évidence était incertaine.

L’écriture numérique est ainsi à distinguer de l’écriture dans un environnement numérique : un ordinateur, Internet, le Web, une calculatrice ou une machine à écrire de la dernière génération. En tant qu’abstraction, l’écriture numérique est une représentation du monde sous forme de chiffres, dont la qualification à travers un medium permet de l’incarner physiquement et matériellement mais pas de la circonscrire. En somme, cette représentation numérique du monde n’est pas nouvelle et ce n’est pas l’ordinateur qui l’a apporté. À notre connaissance, son origine remonte aux prémisses de l’écriture et des développements des systèmes monétaires, nous dirait C. Herrenschmidt (2023).

Dorénavant, lorsque nous ferons référence à l’écriture numérique nous parlerons d’une écriture numérique dans un environnement informatique.

Avant d’entamer une réflexion sur l’écriture numérique, convenons d’une brève définition de l’écriture, car celle-ci a fait couler beaucoup d’encre à son sujet, notamment depuis sa reconfiguration numérique au crépuscule du 20e siècle. La définir tient généralement de la philosophie depuis Platon (2007, p. pp.301‑310), de l’anthropologie Leroi-Gourhan (2022b), des lettres (Christin, 1999; Ong, 2014), de l’archéologie ou de la linguistique (Herrenschmidt, 2023), de la sémiotique (Souchier & Jeanneret, 1999) ou encore des sciences de l’information et de la communication (Bachimont, 2000; Crozat et al., 2011) ou de l’étude des médias (F. Kittler, 2018) et cela pour ne mentionner qu’une infime partie des textes traitant ce sujet parmi un nombre restreint de disciplines de la sphère académique.

Très largement, l’écriture est entendue comme « mode d’expression » et « fonction de communication » au sein d’une société (Christin, 1999). Anne-Marie Christin distingue deux tendances principales de l’origine de l’écriture : l’écriture selon la trace, étant soit comprise comme le signe verbal transposé sur un support soit comme la marque laissée par un corps, soit l’écriture selon le signe dans son sens étymologique d’« événement inaugural [qui] participe d’une révélation » tant qu’il s’inscrit dans un « système » telle que la disposition des entrailles d’une bête sacrifiée lors d’une cérémonie (Christin, 1999; Vitali-Rosati, 2020). À défaut de prendre parti pour l’un ou l’autre de ces paradigmes, nous pouvons retenir deux caractéristiques qui leur sont communes et qui peuvent caractériser toutes formes d’écriture, même numérique. La première est que lorsque l’écriture est convoquée, elle fait appel à deux actions : l’inscription et l’interprétation (Christin, 1999; Pédauque, 2006). Qu’il s’agisse d’une trace ou d’un signe, retenons que l’écriture est toujours inscrite sur un support et que cette inscription fait l’objet d’une lecture et d’une interprétation. Cette association apparaît régulièrement dans les travaux qui traitent de l’environnement numérique, par exemple sous l’appellation de littératie numérique chez Milad Doueihi (2011) ou de lettrure chez Emmanuel Souchier (2012). La seconde caractéristique est son inhumanité (Ong, 2014; Vitali-Rosati, 2020). En s’appuyant sur l’origine divine de l’écriture que Platon fait raconter par Socrate dans le Phèdre, Ong la qualifie d’inhumaine, car « elle prétend établir en dehors de l’esprit ce qui ne peut être en réalité que dans l’esprit. Elle est une chose, un produit manufacturé » séparé de sa source vivante et de l’environnement d’où a émergé l’idée avant qu’elle soit inscrite sur son support. La même figure de « Theuth […] le père de l’écriture » (2007, p. [274‑277]), est employée à tout autre dessein par M. Vitali-Rosati. Selon lui, cette vision de « l’écriture-artefact relève d’une interprétation du monde fondée sur un anthropocentrisme constitutif accompagné d’une série d’a priori métaphysiques » cartésiens du sujet qui déverse ses pensées sur un support. Pour argumenter en faveur d’une vision non-anthropocentrée et non dualiste de l’écriture, il s’appuie entre autres sur les travaux de M-A. Paveau et sa

théorie du discours retravaillée par la cognition sociale dans sa version distribuée : l’intelligence est distribuée dans les environnements, humains comme non humains, et l’objet d’analyse est le système, et non seulement les énoncés ou les locuteurs, qui n’en constituent qu’une partie. Il s’agit donc d’une conception du discours comme intégré dans l’ensemble de l’environnement humain et non humain, et non distingué de cet environnement : je souhaite éviter l’approche « égocéphalocentrée » (expression de C. Brassac qu’il emprunte à J.-P. Kaufmann, et qui désigne une approche internaliste centré sur le sujet-locuteur) et logocentrée Paveau (2015).

Cette conception cognitive distribuée implique une « approche écologique » de l’écriture, c’est-à-dire de prendre en considération la totalité de l’environnement duquel elle émerge, ainsi que le sens qu’elle produit, puisqu’« il n’y a pas de rupture entre ce qui est humain et ce qui ne l’est pas, entre l’esprit et la matière, le linguistique et l’extralinguistique, le discours et le contexte » (Paveau, 2013).

Ong, Paveau et Vitali-Rosati, en qualifiant l’écriture de non-humaine (Paveau, 2015) ou d’inhumaine, nous propose de ne pas dissocier l’écriture de l’écriture numérique puisque, finalement, la seconde n’est qu’une continuité de la première. Pour Ong, l’écriture est alors toujours considérée comme une technique, un outil, qu’elle soit numérique ou non, dont les limites d’extériorisation et de cristallisation de la pensée restent inchangées malgré les changements de support. Tandis que pour Paveau et Vitali-Rosati, le qualificatif d’inhumain renvoie à cette cognition distribuée, située dans des « interactions sociales, culturelles, techniques et technologiques » (Vitali-Rosati, 2020) et non dans un logos.

Lorsqu’il s’agit d’observer l’écriture numérique à la loupe, on remarque qu’elle se distingue d’une écriture plus traditionnelle par trois caractéristiques que sont la calculabilité (Crozat, 2016), la variabilité (Bouchardon, 2014) et la rupture sémiotique entre le geste d’écriture et l’inscription sur le support (Bonaccorsi, 2020; Pédauque, 2006; Souchier, 2019).

La première caractéristique est d’ordre computationnel : l’écriture devient calculable et peut donc faire l’objet d’instructions. Pour réaliser cette action, on procède à une équivalence où chaque signe que l’on peut inscrire dans cet environnement à son pendant unique sous forme de bits. Lorsque chaque caractère peut être identifié en tant que nombre, il devient possible d’implémenter ce modèle dans une machine et de lui demander, grâce à des instructions, d’appliquer des calculs.

L’exemple idéal pour illustrer cette caractéristique n’est rien de moins que la machine imaginée par Alan Turing, qu’il présente en 1936 dans son article «On Computable Numbers, with an Application to the Entscheidungsproblem» dans la section Computing machines (1936). Ce que Turing décrit n’est pas une machine physique mais un modèle théorique, une machine abstraite fondamentale pour les développements futurs de l’informatique. Cette machine est constituée de plusieurs éléments :

- un ruban («tape») divisé en sections (appelées «square») dont chacune peut porter un symbole (0 ou 1 car cette machine est dans un système binaire)

- un organe de lecture («scan») pour lire les symboles un à un («scanned square and scanned symbol») et un organe d’écriture pour modifier un symbole ou en écrire un nouveau si la section est vide

- une mémoire pour se rappeler des sections déjà scannées («remember some of the symbols which it has been “seen” (scanned) previously»)

- des instructions pour se déplacer sur le ruban, soit d’une case vers la gauche soit d’une case vers la droite, lire et écrire («scan and print») ou modifier la case scannée et se re-déplacer avant de s’arrêter.

Théoriquement le ruban sur lequel la machine exécute ses programmes est infini vers la gauche et la droite et cela afin de permettre l’exécution des instructions les plus complexes. La machine de Turing ne s’intéresse pas aux résultats des instructions ni à leur signification, d’où résulte une forme d’automatisation de l’écriture. L’espace de la machine, aussi vaste soit-il, n’est composé que de séries de 0 et de 1 ainsi que de différents états, renvoyant à des instructions et permettant ainsi à la machine de modifier son propre espace. Cette capacité de modification peut être associée à la deuxième caractéristique de l’écriture numérique que S. Bouchardon nomme la variabilité6.

Le passage du signe à l’unité atomique et discrète qu’est le chiffre signifie un changement de représentation du monde (au sens que K. Hayles donne au terme worldview (2005)) : le monde – ou l’espace – n’est alors plus signifié par des mots ou des concepts, mais le devient par des chiffres. Comme McLuhan nous le rappelle dans son ouvrage Pour comprendre les médias (1977), les alphabets composés de lettres (contrairement à ceux composés de pictogrammes) sont asémantiques. Si toutefois les alphabets sont liés à une culture d’où ils émergent, l’abstraction nécessaire pour représenter le monde sous forme de chiffres détacherait a priori cette vision de tout sens. En dehors de tout modèle mathématiques abstrait, et cela quel que soit le langage ou la base utilisée pour l’écrire, 3, trois, three, III, 0011, zéro zéro un un, un chiffre ne signifie pas grand-chose s’il n’est pas associé à un système de valeurs particulier, par exemple le système métrique ou le système international (Herrenschmidt, 2023). En échange de cette perte de signification, l’écriture numérique y gagne cette particularité d’être calculable et mesurable.

L’écriture numérique se distingue également des autres types d’écriture par une troisième caractéristique. Il s’agit de la première forme d’écriture où le geste d’écrire ne correspond pas à l’action d’inscription du signe sur son support, phénomène que J. Bonaccorsi nomme également déliaison (Bonaccorsi, 2020). Lorsqu’on appuie sur une touche du clavier, par exemple la lettre a, elle ne s’inscrit pas dans l’écran : l’instruction d’inscrire un signe dans la mémoire de l’ordinateur est d’abord donnée à la machine, puis vient ensuite celle de l’afficher à l’écran au moyen d’un logiciel particulier (F. A. Kittler, 2015; Souchier, 2019). Néanmoins, le fait d’appuyer sur une touche du clavier lorsque l’ordinateur est sous tension ne suffit pas pour déclencher cette instruction : si aucun environnement dédié à l’écriture n’est lancé au préalable, le fait d’enfoncer une touche du clavier ne déclenchera aucune réaction de la part de la machine. Par contre, lorsque l’on se situe dans un environnement où cette réaction est attendue, comme un éditeur de texte, la frappe d’une touche déclenchera un événement et le logiciel pourra générer l’instruction correspondant à l’action d’écrire.

Ces trois caractéristiques de l’écriture numérique ne sont pas uniquement des propriétés qui s’ajoutent à l’existant et, d’une certaine manière, rendrait l’écriture plus complexe. L’écriture, nous l’avons évoqué, peut être ramenée aux actions d’inscription dans la matière et de lecture. Or, la calculabilité, la variabilité et la déliaison entre geste et inscription abonde dans le sens d’une écriture inhumaine puisque l’inscription et la lecture des caractères et/ou traces sur le support numérique sont des actions réalisées par la machine et ne le sont plus par l’être humain, comme le souligne F. Kittler (F. A. Kittler, 2015). F. Kittler poursuit sa réflexion plus loin jusqu’à soutenir, de manière provocatrice, que l’humain n’écrit plus et qu’à l’ère du numérique, c’est la machine qui écrit. À défaut de prendre cette provocation au pied de la lettre, elle ouvre la perspective d’une machine qui participe et contribue à l’écriture et, ce faisant, participerait à la production d’une épistémologie du texte et du document.

Seulement, la machine ou l’ordinateur sont des appellations vagues et ne rendent pas très explicite les éléments qu’elles désignent, ni ceux qui sont impliqués dans cette action d’écriture et dans cette relation entre humain et machine.

La représentation d’un ordinateur est souvent associée à un couple matériel / logiciel. La partie matérielle concerne tous les composants électroniques (carte mère, mémoires, périphériques, etc.), alors que la partie logicielle englobe tous les programmes permettant d’interagir avec la partie matérielle, comme le BIOS (Basic Input Output System), le système d’exploitation ou encore un logiciel de traitement de texte comme LibreOffice.

Ce couple matériel / logiciel range l’ordinateur dans la catégorie des appareils programmables. La plupart de nos appareils du quotidien ne sont pas programmables : ils exécutent ce pour quoi ils sont conçus et ne font rien d’autre. Dans le cas d’un ordinateur ou d’un téléphone intelligent, ou de tout autre appareil programmable, leur conception prévoit qu’ils soient manipulables : ils n’ont pas de fonction précise, néanmoins ils sont capables de répondre à plusieurs fonctions. Un ordinateur qui n’a aucune instruction ne pourra rien faire une fois alimenté. C’est là que les logiciels interviennent : ils permettent un usage déterminé d’un ordinateur en manipulant des informations de façon à exécuter une suite d’instructions formelles.

Pour fonctionner, un ordinateur n’a besoin que des éléments suivants : une alimentation, un processeur, une mémoire vive, des entrées et sorties et une carte mère auxquels viennent s’ajouter un certains nombres de périphériques (écrans, souris, clavier, etc.), des extensions pour prendre en charge une partie des calculs que l’on peut appeler des cartes filles (carte son, carte graphique) et des mémoires de stockage (disques durs).

Le processeur, ou microprocesseur pour les ordinateurs modernes, est le calculateur central de l’ordinateur, c’est cet élément qui manipule toutes les données à traiter – que l’on appelle aussi le(s) cœur(s) de l’ordinateur. Chaque modèle de processeur à une architecture qui lui est propre, ce qui veut dire que chacun traite les informations différemment (même si le résultat obtenu est identique). Un processeur est un assemblage de multiples types de circuits dont l’élément le plus petit est le transistor. L’évolution des processeurs a suivi la loi Moore jusqu’au début des années 20207, date à partir de laquelle nous arrivons à la limite physique de la miniaturisation d’un transistor.

Le premier processeur commercialisé, le processeur Intel 4004, l’a été en 19718. Il s’agissait d’un processeur 4-bits comportant pas moins de 2300 transistors. Lors de la commercialisation de cet objet s’opère un changement radical dans la conception des ordinateurs puisque, dès lors, du fait de la miniaturisation de ce composant, les ordinateurs deviennent accessibles au grand public. En suivant la première loi de Moore, les microprocesseurs ont continué à évoluer jusqu’à atteindre le nombre de plusieurs milliards de transistors par processeur, démultipliant ainsi leur capacité de traitement des informations.

Cette miniaturisation est rendue possible par la gravure des transistors dans des disques de silice (wafer) plutôt que l’usage plus coûteux et instable de relais et de tubes électroniques. Un transistor est un composant électronique dont le rôle est de laisser passer ou non le courant grâce aux propriétés du semi-conducteur à partir duquel il est fabriqué. En fonction de la valeur du courant qui lui est appliqué, le résultat associé à ce courant sera 0 ou 1. Ce transistor est l’élément physique qui incarne les portes logiques (ET, OU, OUI, NON, XOR, etc.) et traitent les données. Parmi tous les traitements possibles, certains nécessitent de garder en mémoire des résultats intermédiaires pour aboutir. Ils sont alors stockés dans la mémoire vive en attendant d’être réutilisés.

Toutes ces informations traitées, qu’elles soient transformées ou mémorisées, proviennent de ce que l’on nomme des entrées. Ce sont ces entrées qui encodent les informations en chiffres. Une fois traitées, ou lorsqu’elles sont appelées par un programme, ces données transitent par les sorties. Elles font la transformation inverse et décodent les chiffres en caractères humainement interprétables.

L’encodage et le décodage des caractères accompagne toute l’histoire de l’informatique (et du numérique). Aux prémices de l’informatique, chaque matériel comportait ses propres programmes et tables d’encodage, rendant possible la transposition des données d’un matériel à un autre par équivalence. Cependant, dans la plupart des cas, les données ne pouvaient pas circuler entre les différents modèles d’ordinateur, ou alors au moyen de transformations fastidieuses, rendant ainsi les traitements réalisés sur les données enfermées dans des silos. La norme ASCII (American Standard Code for Information Interchange) fait son apparition dans les années 1960 pour résoudre l’enjeu d’interopérabilité de l’encodage des données. Soumise à l’American Standards Association (d’abord ASA puis ANSI) en 1961 par l’un de ses inventeurs, Bob Bemer, puis approuvée en 1963, l’ASCII permet d’encoder 128 caractères sur 7 bits. Néanmoins, ce n’est pas parce qu’un encodage est reconnu en tant que norme que son usage est effectif à l’instant même de sa reconnaissance. Il faut attendre 1968 que le président des États-Unis d’Amérique Johnson demande à ce que l’ASCII devienne la norme fédérale d’encodage des informations afin de réduire les incompatibilités au sein des réseaux de télécommunication pour qu’elle commence à se répandre. Dès 1969, tous les ordinateurs achetés par le gouvernement des États-Unis étaient compatibles avec la norme ASCII. Du côté des ordinateurs personnels, il faudra attendre le début des années 1980 pour que cette norme se répande grâce, entre autres, à son implémentation dans les ordinateurs construits par IBM. La norme X3.4:1986 en vigueur aujourd’hui, a été déposée auprès de l’ANSI en 1986. C’est à partir de cette norme que d’autres ont été développées et restent compatibles ASCII, comme c’est par exemple le cas de la norme Unicode, publiée en 1991, qui est la plus répandue de nos jours puisqu’elle encode le plus de caractères. Si ASCII contient 128 points de code, le standard Unicode permet d’en encoder plus de 149 000 sur une vingtaine de bits par point de code dans sa version 15.1 (de 2023). Afin de préserver cette compatibilité entre les normes, il est d’usage d’encoder les 128 premiers caractères de façon identique à la norme ASCII.

Pour pouvoir utiliser ces tables d’encodage et stocker des données dans la mémoire d’un ordinateur, les utilisateurs ont besoin d’une interface les rendant accessibles et manipulables. Ces interfaces peuvent être rangées sous l’appellation de logiciel. Il est intéressant d’introduire les logiciels et leur fonctionnement à partir du matériel composant l’ordinateur et plus particulièrement à partir de la carte mère. Les fournisseurs de carte mère incorporent généralement dans leur carte une première couche d’abstraction matérielle, un BIOS (Basic Input Output System9), flashé dans la mémoire morte de l’ordinateur et programmé pour s’exécuter lors de la mise sous tension de ce dernier. Ce que l’on appelle couche d’abstraction matérielle en informatique représente la couche logicielle qui se trouve entre la partie matérielle et le système d’exploitation. Comme son nom l’indique, la fonction principale de cette couche est de permettre la manipulation du matériel tout en faisant abstraction de celui-ci. Le BIOS, ce tout premier jeu d’instructions qu’un ordinateur réalise, est un programme propriétaire chargé d’initialiser la séquence d’amorçage (boot) de l’ordinateur, de trouver le système d’exploitation, les périphériques (a minima le clavier et l’écran) et d’opérer quelques vérifications de bon fonctionnement des composants comme c’est le cas de l’horloge temps réel qui fonctionne en tout temps, même lorsque l’ordinateur est éteint, et rythme la totalité des cycles des autres circuits. Hormis quelques rares initiatives telles que Libreboot10 et Coreboot11, des logiciels libres et open sources chargés de remplacer partiellement le BIOS propriétaire, la majorité des cartes mères sont liées à leur BIOS du fait de l’ajout par Intel, à partir de 2006, d’un sous-programme nommé Management Engine (ME) qui est accompagné d’un ensemble de modules comme Boot Guard et Secure Boot dont l’objectif est de veiller à ce qu’il n’y ait pas de corruption du système d’amorçage de l’ordinateur12. Ces programmes ont sans cesse été améliorés depuis leur introduction en 2006 et, aujourd’hui, ils empêchent toute modification de cette couche logicielle, la plus basse d’un ordinateur, si celle-ci n’est pas vérifiée et validée (avec un système de clés cryptées) par la firme propriétaire/fabricante. Il y aurait donc, au plus bas niveau d’abstraction matérielle dans un ordinateur, une imposition d’une vision de la machine aux utilisateurs, réalisée par les quelques sociétés qui détiennent le monopole de la production de ce composant.

Le BIOS est donc l’interface entre l’utilisateur et la machine qui nous permet de manipuler les différentes entrées et sorties du système, donc de gérer les périphériques, fonction que le système d’exploitation peut également réaliser une fois que la phase d’amorçage est terminée. Le système d’exploitation (OS pour Operating System), est un niveau d’abstraction supplémentaire et se retrouve à l’interface entre les applications logicielles et la couche matérielle. Un OS est composé d’un ensemble de programmes permettant la bonne gestion des ressources de l’ordinateur : mémoires, calculs, périphériques, registres, etc. Chaque OS a un fonctionnement qui lui est propre : l’architecture des informations – l’arborescence des dossiers, l’indexation des documents et des fichiers binaires change selon l’OS utilisé –, l’ordonnancement des tâches pour le processeur ou encore l’allocation de la mémoire, etc. Même si cela n’a pas toujours été le cas, les applications logicielles sont maintenant installées à l’intérieur des systèmes d’exploitation et prêtes à être exécutées à partir de ce niveau d’abstraction de la couche matérielle. Le passage par un système d’exploitation permet aux logiciels de ne plus dépendre d’un modèle particulier du hardware et d’en faire justement abstraction, les rendant ainsi opérables sur différentes machines.

Ce tour d’horizon des particularités de l’écriture numérique et de l’agencement entre logiciel et matériel dans la machine nous montre que la conception de la machine ne permet pas à un auteur d’y inscrire des signes dans sa mémoire, ni de pouvoir les consulter directement puisqu’elle lui est inaccessible à moins qu’un intermédiaire ne servent d’interface. La médiation entre une machine et un auteur se fait au moyen d’un langage compréhensible par les deux parties, que l’on assemble sous la forme d’instructions qui, une fois empaquetées, forment un logiciel. Pour symboliser la médiation du matériel par la mise en place du logiciel à l’interface de l’humain et de la machine, l’entreprise Microsoft emploie la métaphore de la fenêtre (window(s)) à travers laquelle l’usager accède à l’espace numérique, et donc l’ordinateur. Pourtant, il ne faut pas s’y méprendre, quelle que soit la fenêtre logicielle, elle ne permet d’accéder qu’à un certain nombre fini d’instructions. Alors qu’en tant qu’appareil programmable qui ne se préoccupe pas de la signification du traitement des informations ni des résultats obtenus, l’ordinateur semble être un environnement beaucoup plus vaste que ce que cette fenêtre ne nous laisse croire (Turing, 1936). Plutôt qu’une fenêtre comme ouverture ou passage vers le numérique, il serait plus juste de considérer cette fenêtre comme une vision du monde parmi d’autres. Cette vision du monde n’est pas seulement une vision particulière que l’humain a de la machine car dans ce cas nous serions dans un paradigme anthropocentré et utilitariste de la machine. En nous déplaçant de l’autre côté de la fenêtre, on se rend compte que la vision que porte la machine sur le monde est différente de la nôtre : la machine incarne une autre vision du monde sous forme de matrice, où chaque élément qu’elle perçoit l’est sous forme binaire. Le monde n’est alors plus que chiffres, calculs et distances, comme c’est le cas de la proposition de K. Hayles lorsqu’elle remplace Mère Nature par une Matrice (Hayles, 2005).

Un début de relation s’instaure entre l’humain et la machine grâce à l’entremise du logiciel. À travers cette interface, lorsque l’on touche une lettre du bout du doigt, la machine devient alors accessible et l’impulsion (électrique) que cette action génère se transforme en une lettre à l’écran. Pour autant, cette accessibilité est-elle un synonyme de mise en visibilité ? Le fait que “ça marche” rendrait-il le document plus visible ? Au contraire, c’est le rôle de l’interface graphique et des métaphores qu’elle véhicule que de cacher le fonctionnement même de la machine (Jeanneret, 2011). La déliaison convoquée par Bonaccorsi (Bonaccorsi, 2020) prend place dès cet instant dans le processus d’écriture puisqu’il ne s’agit pas seulement de délier le geste de l’inscription mais également de faire abstraction de tout le processus d’écriture au-delà du geste. Ainsi, le logiciel aurait une double fonctionnalité : la première est une médiation qui ouvre le dialogue avec la machine tandis que la seconde en fait abstraction et la cache, ce qui a pour effet de rendre la machine quasiment invisible à l’utilisateur. Cependant, que découvrons-nous lorsque nous retirons ce voile devant la fenêtre ? Là se dévoile un vaste écosystème constitué de formats, des protocoles et leurs flux d’informations et de documents, parfois temporaires, voyageant d’une étape à une autre, prenant forme et se transformant pour suivre un cheminement prédéfini jusqu’à la création d’un document final que l’utilisateur récupère. Chacune de ces fenêtres offre finalement une vision particulière d’un document et un modèle épistémologique qui lui est propre (Vitali-Rosati, 2018).

L’interaction entre un humain et une machine consiste en une série d’instructions que donne l’utilisateur à la machine qui, ensuite, les exécute. Le mécanisme sous-jacent à ce que l’on considère communément comme l’écriture numérique – frapper une touche du clavier et voir la lettre s’afficher à l’écran – s’avère être plus complexe. Le moment de la frappe n’est plus le moment où le symbole que l’on voit figurer sur la touche du clavier est inscrit dans le disque dur, il s’agit plutôt du moment où une instruction est donnée à l’ordinateur qui ensuite se charge d’inscrire la lettre correspondante sur le disque dur. Si l’on se trouve dans le cas de figure de la saisie d’un texte dans un éditeur de texte, l’instruction suivante, selon les logiciels et les actions souhaitées, consiste à afficher à l’écran le symbole encodé dans la mémoire de l’ordinateur.

Pour réaliser cette suite d’actions, Yves Jeanneret et Emmanuël Souchier partent de ce constat qu’il n’est pas possible d’écrire un texte numérique sans qu’un autre texte soit déjà présent pour réaliser cette action. Ce texte particulier qui pré-existe toute activité numérique est nommé architexte (Souchier, 2019).

L’architexte est un concept d’abord employé par Gérard Genette (1979) et désigne « l’ensemble des catégories générales, ou transcendantes – types de discours, modes d’énonciations, genre littéraires, etc. –, dont relève chaque texte singulier ».

En 2019, dans leur ouvrage intitulé Le numérique comme écriture, G. Gomez Mejia, W. Candel et E. Souchier résument l’architexte numérique comme :

Initialement défini comme “écriture d’écriture” puis comme un “dispositif d’écriture écrit”, l’architexte s’avère être un point de passage obligé pour toute activité numérique. Il n’y a effectivement pas d’écriture à l’écran sans un architexte qui la rend possible, l’accompagne et la formate. Pour la première fois de son histoire, l’homme a donc recours à des “dispositifs d’écriture écrits” spécifiques pour pouvoir pratiquer une activité d’écriture (E. Souchier, 1998, 2013). Or, précisément en ce qu’ils sont “eux-mêmes écrits”, les architextes “sont des textes lisibles et interprétables. Porteurs et prescripteurs d’une écriture à venir, ils anticipent de ce fait une figure de l’auteur” (É. Candel, G. Gomez Mejia, 2013) et relèvent donc de “l’énonciation éditoriale” (E. Souchier, 1998).

Globalement, l’architexte incarne le cadre dans lequel les agents peuvent écrire. Il permet de faire la distinction entre un gabarit, entendu comme l’espace proposé par les éditeurs de logiciels ou applications pour écrire, et le texte saisi par l’utilisateur, c’est-à-dire le texte qui remplit le gabarit. Cet architexte, ce cadre, est régi par des règles qui définissent comment l’on peut écrire sur un support numérique mais également comment les caractères à inscrire doivent être formatés.

Nous l’avons vu, l’architexte se positionne en tant que médiateur entre un auteur et la machine qu’il emploie pour écrire. Jusqu’à présent, la définition de l’architexte englobe largement tous les écrits qui permettent d’écrire à l’écran. En 2019, G. Gomez-Mejia, E. Souchier et E. Candel précisent ce que sont ces méta-écritures et en dressent une typologie composée de quatre « cadres d’écrits d’écran » :

- le matériel

- le système

- le logiciel

- le document

En régissant ainsi les procédés de saisi du texte à tous les niveaux, un rapport de force semble s’instaurer entre les instances éditrices des architextes (que ce soit des collectifs, des institutions ou des entreprises) et les usagers (Jeanneret & Souchier, 2005). Dans le cas d’un logiciel de traitement de texte lorsque, par exemple, Microsoft propose une modification de la police utilisée par défaut dans une version actualisée du logiciel MSWord, Microsoft change également les manières d’écrire de tous les individus à travers le monde qui utilisent ce logiciel (et qui ont installé la mise à jour).

Si l’on s’arrête à la vision superficielle du texte, comme le propose J. Goody avec la raison graphique (Goody, 1979), on ne voit que les modifications d’affichage des éléments graphiques, mais nous oublions ceux qui sont invisibles et cachés derrière la page.

Certes, les interfaces d’écriture sont présentées sous la forme de gabarits que l’on doit remplir, comme on peut le faire avec des logiciels de création de diapositives dont chacune est découpée en sections contenant tour à tour des images, des titres ou du texte. Dans cet exemple-ci nous avons affaire à une construction visuelle du document : un emplacement pour le titre de la diapositive, un autre pour le texte, un autre pour une image ou pour un graphique, etc. À ce sujet, E. Tufte (2003) a publié un article sur l’utilisation du logiciel PowerPoint et démontre à travers plusieurs cas d’étude les effets du logiciel sur la forme des présentations et des informations qu’elles contiennent. La thèse qu’il y défend est que ce logiciel, en 2003, « […] perturbe, domine et banalise systématiquement le contenu. » 13 notamment parce qu’il « facilite activement la réalisation de présentation légère »14. À travers son analyse des usages de PowerPoint, E. Tufte nous montre qu’il ne s’agit pas d’un manque de fonctionnalité pour enrichir des supports de présentation, que l’auteur qualifie de pauvres, mais que le logiciel lui-même induit ce type de présentation avec des templates préfabriqués, des réalisations de graphiques automatisées ou d’autres fonctionnalités similaires qui appauvrissent les présentations parce que leur fonctionnement est calqué sur un modèle de présentation marketing qui n’est pas adapté aux sciences. Il ne s’agit plus seulement de remplir des gabarits préfabriqués mais également de penser les formes que peuvent prendre l’information, ce que Tufte nomme « The Cognitive Style of PowerPoint », qui n’est pas sans rappeler la raison computationnelle de Bruno Bachimont (2000).

En changeant de paradigme, de la raison graphique pour celui de la raison computationnelle, l’assujettissement à ces architextes dépasse cette surcouche graphique et concerne également toutes les sous-couches (in)visibles de structuration du texte, mais aussi tout le processus d’inscription du document dans la mémoire, ainsi que les protocoles et méthodes qui permettent d’accéder à ces données. Comme nous l’avons vu précédemment, ce n’est pas l’image du texte affichée à l’écran qui est sauvegardée mais bien une suite de caractères binaires dont l’écriture intermédiaire est composée de chiffres et de lettres.

Pourtant, on constate un paradoxe entre le nom d’un logiciel comme Pages, un traitement de texte disponible sous MacOS convoquant la métaphore de la page comme imaginaire en y enfermant les utilisateurs, et le rôle de guide qu’il doit remplir dans le traitement des informations. Dans ce cas-ci, le nom du logiciel ne réfère ni à son fonctionnement ni à son utilité. Alors que dans les années 1980, lors de la genèse des traitements de texte, les lettres WP signifiaient WordPerfect15, et que la plupart des autres concurrents employaient également le mot word dans le nom de leur logiciel, car c’est bien le mot et son traitement informatique qui était au centre des développements, la démarche d’Apple en 2005 nous montre un changement de perspective : on passe du mot à la page. L’attention est portée à un autre endroit, sur une page que génère Pages et qui n’existe pas dans d’autres environnements. La page créée dans cet espace n’est pas reproductible ailleurs même si le document qui en résulte est ouvert, à un autre moment, par le biais d’un autre logiciel. La page de Pages devient un espace délimité qui n’existe sous cette forme qu’à cet endroit. Depuis vingt ans que cet outil est nativement disponible sur les ordinateurs de chez Apple, la compatibilité avec d’autres formats et/ou logiciels augmente tardivement, en témoigne les arguments de communication mis en avant sur la page web du logiciel16, mais compatible ne veut pas dire identique. En plus de n’être accessible que sous MacOS, cette page ne l’est également que sous Pages : cette formulation courante laisse entendre que l’utilisateur devient alors sujet de son environnement d’écriture, nous dit F. Kittler (2015).

Cette position kittlerienne, que l’on peut qualifier d’essentialiste, pose les fondations des travaux de K. Hayles (Hayles, 2005), du posthumanisme, et du nouveau matérialisme, courants dans lesquels s’inscrivent en outre les travaux de K. Barad (2007, 2023) et ceux de M. Vitali-Rosati (2021). Pourtant, leur approche du rapport entre humain et machine est radicalement différente de celle de F. Kittler. Alors que F. Kittler identifie la machine et l’utilisateur par une série de propriétés ou définitions avant leur interaction, quasiment de manière décisive, les posthumanistes choisissent de ne pas déterminer les agents préalablement à l’environnement mais comme résultats de l’agencement de plusieurs dynamiques dans un espace donné. C’est en ce sens que sont mobilisées et développées les notions de worldview ches K. Hayles, où Mère Nature devient une Matrice (My Mother was a Computer), l’intra-action à la place d’interaction puisque les agents ne sont pas prédéterminés chez K. Barad et enfin l’éditorialisation chez M. Vitali-Rosati qui propose une ontologie de la médiation (métaontologie) selon laquelle le media n’existe pas, on y retrouve la provocation de Kittler, et que toutes ces dynamiques, ces intra-actions, sont des médiations dont la matérialité, dans un agencement donné, produit du sens (Vitali-Rosati & Larrue, 2019).

Ainsi, l’assujettissement de l’humain aux logiciels que nous avons mentionné, que F. Kittler critique vivement dans ses travaux, n’a plus de raison d’être dans cette perspective non-essentialiste offerte par l’éditorialisation puisque ces entités sont uniquement déterminées lorsqu’il y a intra-action. Les relations entre les agents ne peuvent plus être présupposées et leur détermination est réalisée depuis un référentiel quasiment unique si l’on considère que les paramètres de cet environnement sont variables et que la probabilité d’obtention de conditions strictement identiques est quasi nulle. Depuis cette perspective où l’on considère les différents agents comme des productions de leur agencement dans un écosystème, il devient intéressant d’observer leur relation tout au long de ce processus pour comprendre comment ils s’affectent les uns les autres.

Pour réaliser cela, le dépassement de l’interface et des métaphores affichées à l’écran devient dès lors un acte symbolique nécessaire pour se soustraire à une vision essentialiste des actions de lecture et d’écriture. Pour effectuer ce changement de perspective, nous devons d’abord nous débarrasser d’un élément central à l’interface de l’humain et la machine : la page.

Le terme page revient de manière récurrente dans nos usages de l’ordinateur : on le retrouve dans les logiciels de traitement de textes dont Pages fait partie, dans les livres numériques ou encore dans le Web où chaque URL est l’adresse d’une page. Matthew Kirschenbaum et Thomas Bergin nous détaillent dans leurs travaux l’arrivée de la page sur nos écrans durant les années 1970 et le début des années 1980 (Bergin, 2006a, 2006b; Kirschenbaum, 2016).

Cet objet qu’est la page a été instauré dans l’ordinateur uniquement pour reproduire une « habitude » et créer un lien fictif entre les visions du monde de l’imprimerie et de l’informatique. Cet artefact produit une forme de réconfort auprès de l’utilisateur pour que le monde informatique lui semble plus tangible, qu’il ait quelque chose auquel se raccrocher, d’où sa déclinaison dans des espaces différents qui ne ressemblent plus du tout à des pages de livres ou des feuilles (par exemple la feuille aux formats A4, lettre US, ou le livre au format poche). La page affichée à l’écran n’existe qu’à cet endroit, il ne s’agit que d’un rendu graphique qui ne fait pas partie de l’écriture (au sens du texte saisi).

Le pouvoir de la page sur l’utilisateur est considérable étant donnée la nature même de cet objet que l’on pourrait considérer comme l’un des seuls à être virtuel et presque sans matérialité du point de vue de l’informatique. Malgré tous les efforts effectués depuis son instauration à l’écran, la page affichée n’est jamais la page imprimée car, aussi précis que soient les détails typographiques que l’on peut y ajuster, elle ne reflétera jamais le grain, l’épaisseur, l’odeur ou tout autre caractéristique physique du papier17.

La critique énoncée à l’endroit de la page ne doit pas être réduite à une apologie d’un mode sans page. Elle consiste à montrer qu’à vouloir préserver une habitude pour ne pas effrayer l’utilisateur, la page fait écran devant l’ordinateur, et cache la machine qui ne devient plus qu’un simple mécanisme au lieu d’être un agent de l’énonciation éditoriale.

Cette peur de l’informatique pourrait relever essentiellement de l’angoisse de l’arrachement d’une valeur qui définie l’être humain et devienne une caractéristique d’une autre entité, ne permettant plus de définir l’humain en regard de ce que lui seul est capable de faire.

Kittler, à ce propos, nous rappelle qu’historiquement les caractéristiques qui définissent l’être humain sont souvent le symbole du pouvoir et désigne plutôt les hommes alors qu’à l’instant même où cette caractéristique est déchue de son statut de marqueur de puissance, ce sont les femmes qui en héritent. Dans le cas de l’écriture – dactylographie et sténographie–, réservée pendant longtemps à la gent masculine, les femmes s’en emparent dès 1881, au moment même où les ventes de la machine à écrire Remington II explosent alors que chute le pourcentage d’hommes dans ce domaine (F. Kittler, 2018, p. 306). La Remington Model II de 1878 comporte une particularité, il s’agit de la première machine à écrire comportant une touche SHIFT pour avoir les hauts de casse et les bas de casse sur le même clavier, pourtant, malgré cette nouvelle fonctionnalité, les ventes ne se développèrent pas dès cette date. En 1881, l’entreprise modifie sa stratégie de vente et cible les femmes qui n’ont pas de travail. En parallèle, l’Association chrétienne de jeunes femmes de New York commence à former des jeunes femmes à la dactylographie, fait qui a été ensuite reproduit en Europe dû à son succès (F. Kittler, 2018, p. 322). Il y aurait donc une peur de perdre non seulement une caractéristique de l’humanité mais surtout une caractéristique de la masculinité.

Néanmoins, avant d’en arriver à cette émotion forte qu’est la peur et qui traduit une incapacité à définir l’être humain, nous pouvons nous appuyer sur la pensée de Gunther Anders et convoquer une forme de honte (Anders, 2002) que la page camoufle.

Interagir avec une machine demande une certaine rigueur : qu’il s’agisse de structurer un document ou de lui donner une série d’instructions (du code), une machine ne peut interpréter l’ambiguïté ou l’implicite culturel. Cela voudrait dire qu’aucun échange humain-ordinateur ne peut reposer sur des conventions culturelles de lecture et que l’instruction donnée n’a, en elle-même, aucun sens. Dès lors, comment pouvons-nous admettre que quelque chose qui n’a pas de sens puisse en générer ?

La honte (prométhéenne) d’Anders est alors double : d’un côté il y a un mélange de fierté devant cette machine créée par l’être humain et de honte parce que l’individu isolé devant la machine sait que ce n’est pas lui qui l’a mise au point et, de l’autre, il y a cette honte à être face à un outil qui réalise une action mieux qu’on ne le ferait soi-même alors que cette dite machine n’a aucune conscience de ce qu’elle réalise.

Le dépassement de la page et de l’écran est une proposition pour poser un autre regard non anthropocentré sur cette question de l’écriture numérique et laisser de côté les modalités de définition de l’être humain en acceptant son caractère inhumain. En dépassant la page, il ne s’agit plus de poser la question de l’auteur de l’écriture, en admettant que c’est bien la machine qui écrit, mais de se demander comment cette nouvelle fonction (inter)agit entre les agents d’un système d’informations. Que se passe-t-il lorsque cet ordinateur devient un agent actif qui écrit et transmet des informations entre, d’une part, l’instructeur (la personne qui donne des instructions) et les documents issus du traitement de ces instructions ? Dans cette configuration s’opère alors un changement radical de l’état de l’ordinateur. D’abord à l’état de médiateur puis de support de l’écriture, l’ordinateur passe maintenant au statut d’entité agissante au sein d’un système d’informations.

Traverser la page pour atteindre les couches inférieures nous amène à faire escale sur la couche logicielle. Le logiciel a un statut intéressant : on le considère souvent comme un médiateur, un agent qui permet la communication et l’interaction humain-machine, pourtant ce n’est pas le cas de toutes les recherches. F. Kittler et sa très célèbre provocation « Es gibt keine Software », traduit par Le logiciel n’existe pas (2015), nous rappelle que ces écritures (qui nous permettent d’écrire), sont stockées et traitées par la machine exactement de la même façon que n’importe quelle écriture numérique.

On retrouve tous ces textes numériques (logiciels et documents) au même niveau hiérarchique dans l’architecture du système d’exploitation et le traitement qui leur est appliqué par le processeur est identique. La nomination des logiciels en tant qu’« écrits qui permettent les écrits d’écran » par E. Souchier nous mène aussi à cette juxtaposition : finalement le logiciel est de même nature que le texte que nous y rédigeons à l’intérieur.

Toutefois, une distinction persiste. Si le texte peut être remédié dans un autre format – et être imprimé par exemple –, le logiciel quant à lui ne peut exister que dans son environnement numérique. Son code source peut lui aussi faire l’objet d’une remédiation (Bolter & Grusin, 1998) mais il sera dénaturé, car sa fonction principale est l’organisation du traitement des informations dans un ordinateur. D’ailleurs, C. Herrenschmidt nous rappelle que le terme de logiciel a été forgé à partir de la contraction du mot logique avec le mot matériel (Herrenschmidt, 2023, p. 474), pour justement montrer à la fois l’opposition du logiciel avec l’aspect matériel (hardware) et marquer leur complémentarité : l’ordinateur (hardware) serait très peu accessible (voire inaccessible) sans logiciel, et le logiciel n’existe pas en dehors de l’ordinateur.

Lorsque l’on définit le logiciel en opposition au matériel, comme nous l’avons énoncé précédemment, nous les positionnons tous deux à la même échelle. Ils en deviennent ainsi faussement comparables et le logiciel se voit doté d’une propriété immatérielle, ce qui a pour effet d’être en totale contradiction avec ce que nous venons d’énoncer sur la place du logiciel aux côtés de n’importe quel document à l’intérieur de la mémoire de l’ordinateur. En suivant les pensées d’Herrenschmidt et de Kittler, s’ils affirment que le logiciel n’existe pas, c’est parce qu’il n’est pas une entité propre, mais est une partie de l’ordinateur. Il en constitue un organe de communication interne et externe à l’ordinateur.

La relation entre un logiciel avec le reste de son écosystème peut être qualifiée de fragile et nécessite une attention particulière puisque l’agencement du logiciel avec le reste de l’environnement ne peut se faire qu’au prix d’une compatibilité entre les divers éléments qui le composent – même si les systèmes d’exploitation récents lissent et camouflent cet aspect-là. Pour fonctionner, le logiciel doit être compatible avec plusieurs composants de l’ordinateur. Les premiers composants sont matériels : est-ce que l’ordinateur a une carte graphique, quel type de processeur ou la quantité de mémoire vive, etc. C’était un fait connu du temps des premiers logiciels comme WordPerfect (Bergin, 2006a; Kirschenbaum, 2016; F. A. Kittler, 2015) et que l’on voit de moins en moins aujourd’hui, notamment parce que 1) les logiciels à installer sont disponibles pour beaucoup de matériels – exceptés pour certains jeux vidéos ou des programmes que l’on va préférer faire fonctionner sur des “machines plus puissantes” avec plus de capacité de calcul – et 2) parce que le développement des téléphones intelligents depuis une vingtaine d’années a donné naissance à un nouveau format d’application : les progressive web apps qui utilisent les technologies du web (HTML, CSS, JS) pour fonctionner et sont donc exécutables sur plus de supports puisqu’elles sont agnostiques18 vis-à-vis du système d’exploitation. L’environnement matériel est donc une première condition pour faire fonctionner un logiciel. Le deuxième composant est le système d’exploitation (et sa version). En fonction du système d’exploitation – et de sa version – un logiciel pourra y être installé à l’intérieur. Ce deuxième paramètre ne doit pas être sous-estimé, car l’écosystème des logiciels fonctionne sur la base d’un système réticulaire : les programmes ne sont pas développés from scratch, ils s’appuient sur d’autres briques logicielles qui elles-mêmes s’appuient sur d’autres briques logicielles. Chacune d’entre elles dépend d’une version particulière de l’autre. Si une version venait à être mise à jour sans vérification préalable, alors le château de cartes pourrait s’effondrer et le logiciel ne plus fonctionner.

D’ailleurs, une pratique courante en développement informatique consiste à créer un environnement virtuel – une bulle – à l’intérieur même de son ordinateur pour y installer des versions sélectionnées de dépendances logicielles afin qu’elles ne soient pas victimes d’un effet de bord dû à une mise à jour d’un autre programme (et d’autre dépendances).

Le logiciel est un langage de haut niveau qui permet de manipuler des données jusqu’au plus bas niveau de l’ordinateur, au niveau des entrées et des sorties. Toutes ces manipulations sont exécutées en appelant des instructions dans ce réseau de dépendances/logiciels pour que les données puissent descendre les couches de l’ordinateur et être transformées jusqu’à atteindre leur espace de stockage dans la mémoire morte.

Le nom qui désigne un logiciel comme MS Word, Stylo ou LibreOffice désignent plus que les vagues notions que peuvent être leur fonctionnalité principale, dans ces cas-ci l’édition de texte. Un logiciel évoque la totalité des instructions nécessaires à la manipulation des informations (ce que nous appelons des fonctionnalités), mais aussi l’intégralité de l’écosystème dans lequel le logiciel fonctionne. À titre d’exemple, les logiciels obsolètes que l’on ne peut plus faire fonctionner dans les environnements récents doivent faire l’objet d’une émulation pour être exécuté : les conditions permettant leur bon fonctionnement sont simulés à l’identique pour reproduire la machine sur laquelle le logiciel a été initialement conçu. Ce phénomène est récurrent dans plusieurs domaines tels que les archives du web ou les jeux vidéos, mais est également valable pour tous les logiciels.

Le logiciel Electric Pencil, premier logiciel qualifié de word processor en 1978 illustre bien ce propos. Si l’on souhaitait en faire l’installation sur un ordinateur fabriqué en 2024, ce ne serait pas une chose très aisée puisqu’il a été développé pour un ordinateur de cette époque, le TRS-80 Model I. Pour réaliser cette installation, il faudrait connaître les spécificités de cet ordinateur et les simuler pour qu’Electric Pencil soit exécuté. C’est en ce sens qu’Electric Pencil embarque avec lui tous les agencements et l’histoire du média pour lequel il a été développé.

À l’instar de McLuhan (1977), l’on pourrait percevoir les logiciels comme des espaces construits – des architectures de l’information (Broudoux et al., 2013) soignées – avec une topologie qui leur est propre et à travers laquelle chaque suite d’instructions forme une route que des unités sémiotiques empruntent pour y être transformées en unités calculables.

Chaque environnement d’écriture incarne un modèle et une vision du traitement de l’information, que l’on peut englober sous le nom de cet environnement. Lors de l’interaction entre un usager et une machine, par le biais de cet environnement, les médiations à l’œuvre sont des dynamiques qui, lorsqu’elles sont agencées dans une configuration particulière, co-construisent un document jusqu’à sa matérialisation.

En prenant le cas de Stylo, nous pouvons détailler ce que désigne cette appellation en fouillant son architecture logicielle, puisque le code est en libre accès, afin de cibler ces dynamiques et mettre en visibilité les étapes de la matérialisation du document primaire.

Les médiations documentaires dans Stylo

Stylo représente un espace sur le Web dans lequel nous pouvons écrire selon la syntaxe de trois formats de texte brut, le Markdown, le YAML et le BibTeX. À la différence d’un espace fermé comme peut l’être un espace local, le Web est un environnement ouvert et accessible pour celles et ceux qui ont un accès à Internet. Il constitue une application d’Internet permettant le transfert d’informations en réseau. Son architecture repose sur deux éléments fondamentaux : un protocole d’adressage des ressources (Internet Protocol, IP) et un protocole de transfert des informations (Transmission Control Protocol, TCP).

Alain Mille en dresse l’histoire depuis les débuts d’Internet dans les années 1960 à partir du réseau filaire ARPAnet développé par le département de la défense américaine (Mille, 2014). À ce stade précoce, comme le souligne A. Mille, il manque une brique technologique pour que naisse l’Internet : un protocole de transfert des documents. Le premier protocole a vu le jour en 196919 et a fait l’objet de la première RFC20 (Request for comments) avant de trouver une forme plus aboutie dans le protocole TCP en 1974 – décrit par Vincent Cerf et Bob Kahn – et permet avec sa distribution sous forme de paquets la naissance d’Internet. Ce n’est qu’en 1990, au CERN (Organisation européenne pour la recherche nucléaire), que Tim Berners-Lee participe à la conception du Web – et du World Wide Web – pour pallier le problème d’échanges de documents numériques rencontré dans cette institution grâce au développement du langage de balisage HTML. Le Web vient donc répondre à un besoin, celui de la compatibilité des informations et de leur interoperabilité dans une structure. En créant un environnement spécifique composé de normes de structuration des informations interprétable par un logiciel, le navigateur, le Web devient agnostique et ne dépend plus de la même couche d’abstraction logicielle qu’un environnement local. L’ordinateur devient un terminal, un client à partir duquel on peut se connecter au réseau et accéder aux informations qui y circulent.

C’est ainsi que sur le Web, l’action de stockage des données est généralement séparée de l’espace d’affichage dans le navigateur. Les données sont stockées dans une base de données sur un serveur. Il y aurait donc au moins deux modules différents, la partie client – ce qui est affiché dans le navigateur – et la partie serveur où sont organisées les informations.

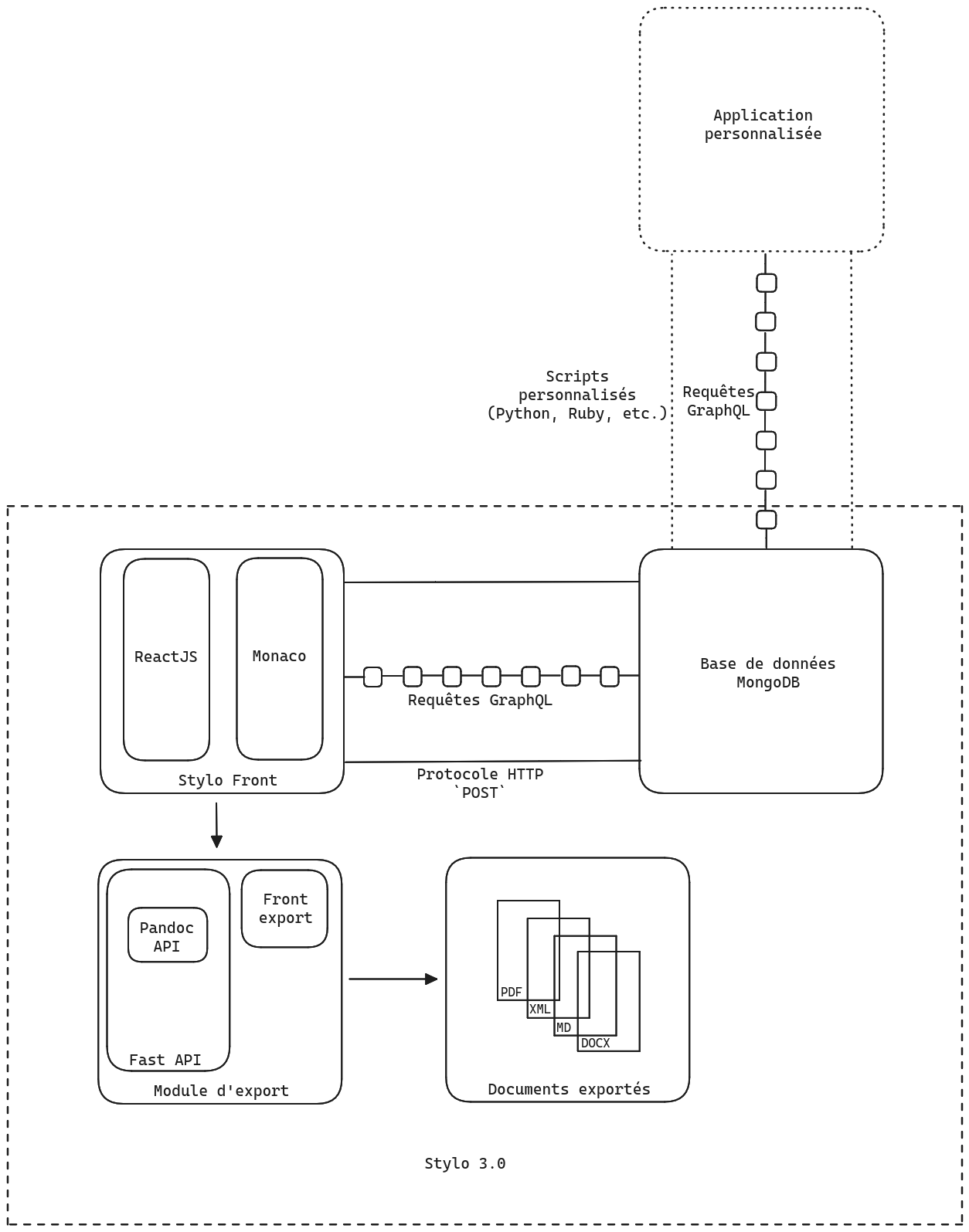

Nous retrouvons ce fonctionnement dans Stylo avec la partie serveur et la partie client auxquelles vient s’ajouter un troisième bloc pour exporter les données afin de les extraire de cet environnement client - serveur. L’architecture logicielle de Stylo peut donc être scindée en trois parties.

Tout d’abord, nous retrouvons la base de données où sont stockées toutes les informations et données de Stylo : les comptes utilisateurs, les articles, les espaces de travail, les corpus, etc. Cette base de données est réalisée avec MongoDB, un système de gestion de base de données non relationnelles développé en 2007 et s’appuyant sur des documents structurés au format JSON.

Le deuxième bloc de Stylo est le module d’export qui permet de transformer les informations saisies et visibles dans l’éditeur en de multiples documents. Tout ce module est développé et maintenu avec le langage de programmation Python par David Larlet. Cette brique technologique est articulée autour du logiciel de transformation et de conversion Pandoc21 déployée sur un serveur et rendue accessible via une autre API22 fabriquée à partir du framework FastAPI23. Le module d’export intégré à Stylo24 permet de convertir et de transformer les textes sources en une multitude d’artefacts, selon les capacités de transformation et de conversion du logiciel Pandoc auquel il est rattaché.

Le dernier bloc de Stylo concerne l’interface que les utilisateurs voient affichée sur leur écran. Étant donné que Stylo est accessible via un navigateur web, l’interface a été conçue avec les technologies de cet environnement. On retrouve des objets en HTML, en CSS et en Javascript. Le framework React, une surcouche à Javascript open source développée par Facebook (aujourd’hui Meta) en 2013, a été employé pour construire les différents composants de l’interface et intégrer de nombreuses librairies telle que i18n qui permet d’implémenter le multilinguisme dans l’interface et de changer la langue affichée à l’écran en un seul clic.

L’éditeur de texte, pièce maîtresse de Stylo, s’appuie sur la technologie Monaco25 développée par Microsoft et rendu disponible sous licence MIT.

Ces deux blocs, la base de données MongoDB et l’interface web, ne sont pas en communication directe. Les champs de texte dans la partie HTML ne permettent pas d’écrire directement dans la base de données. En conséquence, un canal de communication devait être établi entre ces deux objets pour que les données puissent être accessibles à la fois en lecture, pour l’affichage dans la page web, et en écriture pour ajouter, modifier ou supprimer des éléments. Pour mettre en œuvre cette communication, une API (Application Programming Interface) utilisant le langage de requête GraphQL a été mise en place et rendue accessible via le protocole HTTP (Hypertext Transfert Protocol)26, la surcouche du protocole internet utilisée pour le web. Le langage de requête et de manipulation des données GraphQL a également été développé par Facebook à partir de 2012 puis publié en open source en 2015.

L’une des particularités d’une API GraphQL, contrairement à une API REST par exemple, est qu’elle sert l’ensemble des données à une seule adresse (endpoint) alors que plus généralement, les données sont accessibles à des URL très précises, ce qui a pour effet de rendre explicite la structuration des données dans la base. En ne servant les données qu’à une seule adresse, l’API s’échappe de la contrainte de la structuration des données et contourne les problèmes récurrents d’over-fetching ou d’under-fetching que l’on peut rencontrer dans certaines applications27 L’API GraphQL est donc agnostique à l’égard de la forme de la base de données. Par contre, la définition de requêtes adressables à la base de données doit être déclarée pour que l’on puisse faire circuler les informations entre le serveur et le client. Pour effectuer cela, GraphQL à son propre langage de description de schéma (SDL, Schema Definition Language) et permet de déclarer explicitement les différentes façons d’écrire une requête.

Par exemple dans Stylo, le champ user contient les informations suivantes28 :

- _id

- displayName

- username

- authType

- firstName

- lastName

- institution

- tags

- permissions

- acquintances

- articles

- workspaces

- admin

- yaml

- zoteroToken

- createdAt

- updateAt

- apiToken

- addContact

- removeContact

- stats

Une requête simple consisterait à vouloir récupérer l’adresse courriel liée à mon compte utilisateur :

query usermail {

user {

email

}

}et renverrait comme réponse :

{

"data": {

"user": {

"email": "roch.delannay@umontreal.ca"

}

}

}Cet exemple montre qu’il y a une certaine économie de l’information implémentée dans le fonctionnement même de GraphQL pour n’aller chercher que les informations nécessaires pour une requête particulière, pour peu que la requête en elle-même soit bien rédigée. D’ailleurs, il s’agit là d’un des écueils potentiels de GraphQL : des requêtes mal formulées peuvent aller à l’encontre de ce principe.

Dans Stylo, chaque fonctionnalité, chaque bouton (ou presque) qui réalise une action de lecture ou d’écriture est lié à une requête GraphQL et au schéma de donnée correspondant. Chacune de ces actions suit en conséquence une modalité d’inscription dans la base de données se conformant à l’architecture implémentée lors des développements de Stylo. Ce faisant, chacun de ces boutons est une amorce à l’organisation des informations et à la matérialisation du document, puisqu’ils déterminent la manière dont sont traitées les informations. Par exemple, il est toujours possible d’utiliser le champ dédié au corps de texte pour indexer des métadonnées, seulement Stylo n’est pas prévu pour traiter en tant que métadonnées les informations contenues dans l’espace réservé au texte. Elles seront alors traitées comme du texte et perdront leur valeur sémantique.

La circulation des informations entre le client et le serveur ne repose pas uniquement sur GraphQL, qui permet seulement de construire les requêtes liées aux données de Stylo par le biais de l’API. De la même façon que l’on n’envoie pas une lettre à quelqu’un sans service postal, les requêtes GraphQL ne peuvent pas circuler entre la base de données et le client sans un protocole pour les acheminer. Pour être livrée à destination, la carte postale doit respecter plusieurs conditions : elle doit comporter l’adresse du destinataire, être affranchie et enfin être déposée sur le réseau du service postal (soit dans un bureau de poste, soit dans une boîte postale). Si l’on ne respecte pas ce protocole et que l’on décide plutôt de jeter cette carte postale par la fenêtre, il est fort probable que celle-ci n’arrive jamais à destination. Le procédé est similaire pour les requêtes formulées sur les données de Stylo. Pour émettre ou recevoir une requête GraphQL, le client a besoin d’un protocole, soit un ensemble de règles pour formater et véhiculer la requête sur le réseau. Pour Stylo, le protocole employé est HTTP. Ce protocole induit un comportement particulier de notre requête puisque selon son emploi, les informations ne seront pas traitées de la même manière.

Parmi les neuf méthodes de circulation des informations entre un serveur et un client, le protocole HTTP en comporte deux bien connues : GET et POST. Chacune de ces méthodes a un comportement bien défini. Pourtant, un des arguments phares présenté par GraphQL est sa dimension agnostique par rapport au protocole de communication des informations employé, que ce soit HTTP ou des WebSockets ou autre. Malgré la capacité de GraphQL à être utilisable avec toutes les méthodes d’HTTP29, une bonne pratique appliquée par la communauté GraphQL est l’emploi du protocole HTTP couplé à la méthode POST pour tous types de requêtes (que ce soit une query, une mutation ou encore une subscription). Lors de la transmission des informations par la méthode GET, toutes les informations sont insérées dans l’URL ce qui 1) les rend visibles (et vulnérables) et 2) impose une limite du nombre de caractères (aux alentours de 2000 au maximum) au risque de déclencher une erreur 414 (URL trop longue). En conséquence, il est préférable d’utiliser la méthode POST pour envoyer ou récupérer des informations, car elles ne seront ni visibles ni limitées en longueur. Malgré l’aspect agnostique de GraphQL, la forme textuelle des requêtes implique en elle-même un choix particulier de transmission des informations avec ce qu’il comporte comme avantages et inconvénients. En respect de ces bonnes pratiques, la méthode POST a été préférée dans Stylo.

Les spécificités du protocole HTTP sont définies et consultables dans les Request for Comments (RFC) publiés par l’Internet Engineering Task Force (IETF) fondée en 1986 et dont le siège se trouve aux États-Unis. Les documents et leurs contenus sont régulièrement mis à jour par la communauté qui participe à ces commentaires. Le numéro de la RFC en lien avec la méthode POST est le 911030 publié en juin 2022.

La méthode POST est définie dans le paragraphe 9.3.3 comme :

The POST method requests that the target resource process the representation enclosed in the request according to the resource’s own specific semantics. For example, POST is used for the following functions (among others) :

- Providing a block of data, such as the fields entered into an HTML form, to a data-handling process;

- Posting a message to a bulletin board, newsgroup, mailing list, blog, or similar group of articles;

- Creating a new resource that has yet to be identified by the origin server; and

- Appending data to a resource’s existing representation(s).31